Shumai

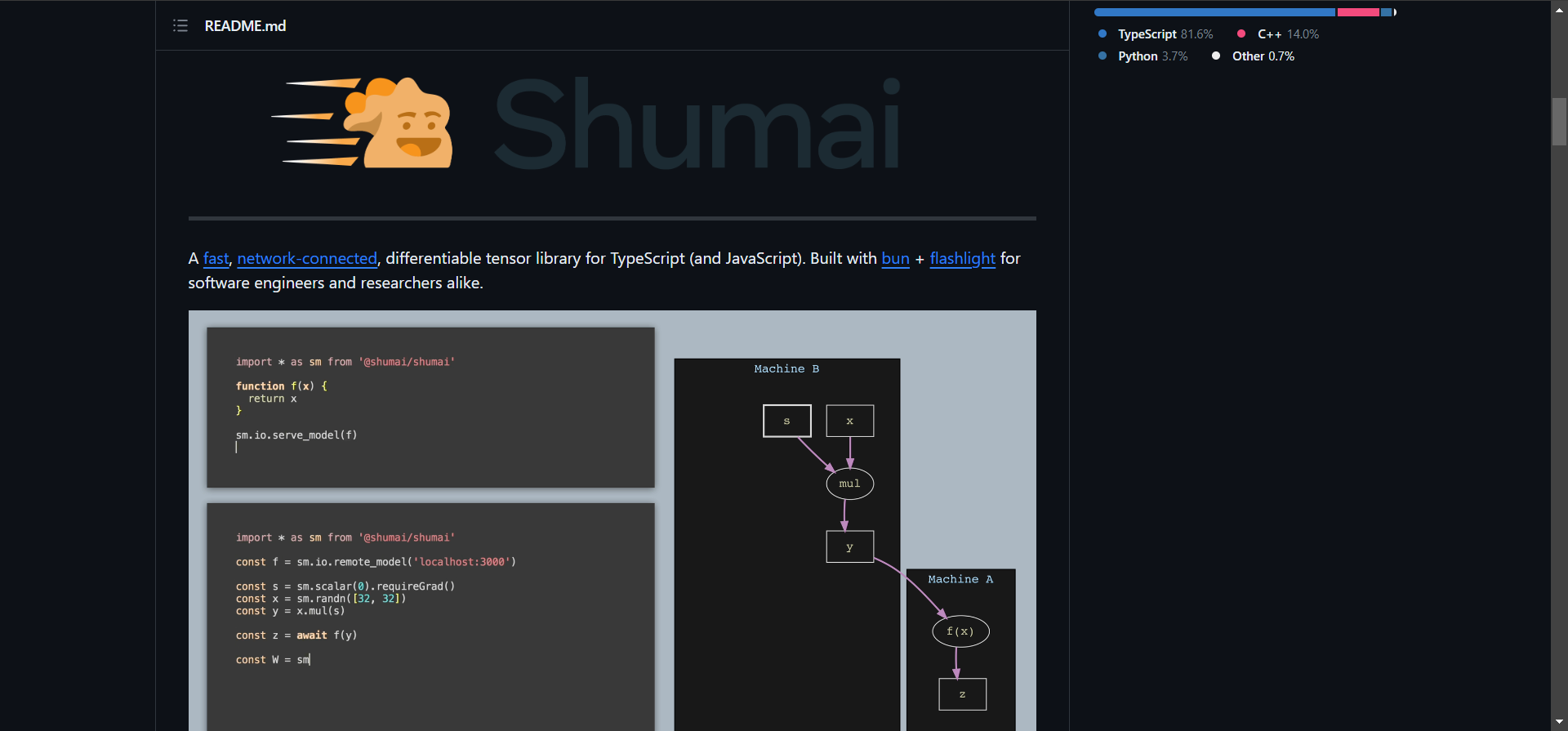

Shumai, ein innovatives Produkt von Facebook Research, macht Fortschritte in der Welt der KI und des maschinellen Lernens. Es ist eine schnelle, differenzierbare Tensor-Bibliothek, die speziell für TypeScript und JavaScript entworfen wurde und Bun- und Flashlight-Technologien integriert. Diese Bibliothek zeichnet sich durch ihre Netzwerkfähigkeit und ihre Attraktivität sowohl für Software-Ingenieure als auch für Forscher aus.

Einer der kritischen Aspekte von Shumai ist seine Konzentration auf die Vereinfachung der Datensatzerstellung. Es nutzt JavaScripts native typisierte Arrays und JIT-Compiler, die ideal sind, um Daten in GPU-kompatible Arrays zu manipulieren. Diese Funktion ist besonders vorteilhaft beim Trainieren kleinerer Modelle, wo Shumais Foreign Function Interface (FFI)-Bindings in Bun bemerkenswerte Geschwindigkeit zeigen, was die Overhead von JavaScript im Prozess erheblich reduziert.

Darüber hinaus erhöht Shumai die Ausdrucksfähigkeit von fortgeschrittenen Trainings- und Inferenzlogiken. Dank des JSC JIT-Compilers von Bun können Entwickler komplexe Trainingslogiken mit Zuversicht schreiben, ohne dass eine native C++-Implementierung notwendig ist. Diese Fähigkeit beschleunigt nicht nur die Entwicklung, sondern eröffnet auch neue Möglichkeiten im Training von KI-Modellen.

Benchmarking-Ergebnisse veranschaulichen weiterhin die Effizienz von Shumai. Im Vergleich zu TF.js (node) zeigt Shumai auf einem Apple M1 Pro bei verschiedenen Operationen einen signifikanten Leistungsvorteil. Beispielsweise erreicht Shumai bei einer 1024-breiten Addition eine um das 4,84-fache schnellere Leistung als TF.js.

Zusätzlich befasst sich Shumai mit Bedenken bezüglich des Speicherverbrauchs. Sein Speichermanagementsystem ist darauf ausgelegt, den Mehraufwand durch den Garbage Collector zu verringern und die Leistung zu steigern. Anwender können Speichereinstellungen wie die obere Schwellenwertgrenze anpassen, deren Überschreitung den Garbage Collector für jeden zugewiesenen Tensor auslöst.

Zusammenfassend ist Shumai eine robuste und effiziente Tensorbibliothek, die die Erstellung von Datensätzen vereinfacht, das Training von Modellen beschleunigt und fortschrittliches Speichermanagement bietet. Ihre Integration in JavaScript-Umgebungen und Leistungsbenchmarks machen sie zu einer überzeugenden Wahl für Entwickler und Forscher im Bereich KI und maschinelles Lernen.